「Hala Point」と名付けられたこのマシンは、CPUやGPUを使用する従来の演算システムと比べて、AIの情報処理を50倍の速度で、かつ100分の1の消費電力で実行できる、とインテルは声明で述べている。なお、これらの数字は3月18日にプレプリントサーバー「IEEE Explore」にアップロードされた報告に基づいており、査読を受けたものではない。

Hala Pointは当面、米ニューメキシコ州にあるサンディア国立研究所に配備され、研究者たちが、デバイス物理学、コンピューティング・アーキテクチャ、コンピューターサイエンスの分野における課題解決に用いる予定だ。

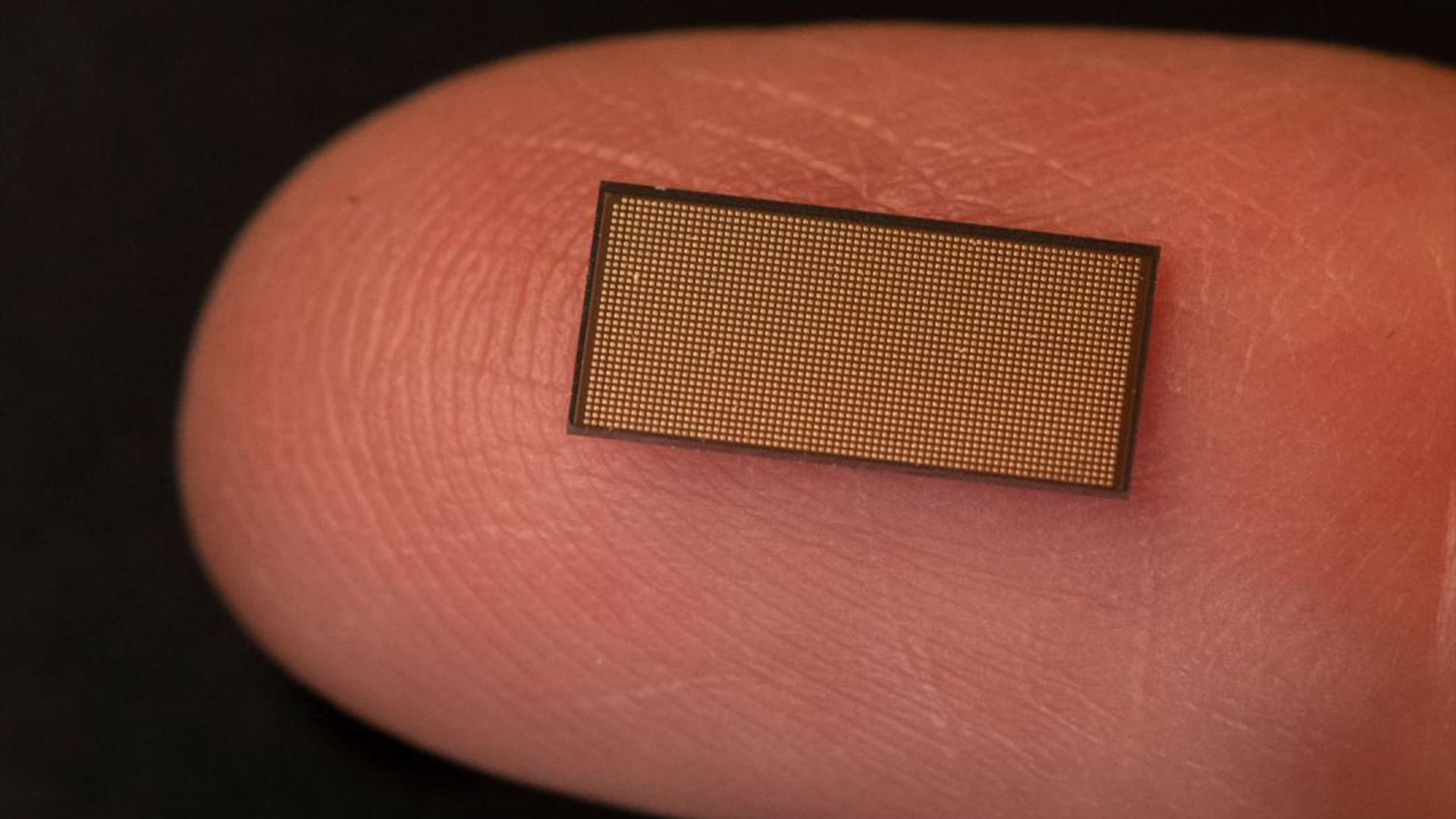

インテルの新型プロセッサ(研究段階のニューロモーフィック・チップ)「Loihi 2」を1152基搭載したこの大規模システムは、11億5000万の人工ニューロンと1280億の人工シナプスで構成されており、これらが14万544基のプロセッシング・コア上に分散している。

Hala Pointは、1秒間に2京回(20 Petaops)の演算処理を実行できる。ニューロモーフィック・コンピューターの情報処理はスーパーコンピューターとは方式が異なるため、比較は難しいが、世界で38番目に高性能なスーパーコンピューターである(ロスアラモス国立研究所の)「Trinity」は約20 petaFLOPSだ(FLOPSは、1秒あたりの浮動小数点数演算回数)。世界で最も高性能なスーパーコンピューターは(オークリッジ国立研究所の)「Frontier」で、その演算性能は1.2 exaFLOPS(すなわち1194 petaFLOPS)だ。

ニューロモーフィック演算の仕組み

オークリッジ国立研究所(ORNL)のコンピューターサイエンティスト、プラサナ・デイト(Prasanna Date)は、「ResearchGate」で公開した論文のなかで、ニューロモーフィック演算は、アーキテクチャの特性によって、従来のコンピューターとは異なる演算方式をとると述べている。このタイプのコンピューターは、マシンを構築する際にニューラルネットワークを用いている。

従来のコンピューターの演算では、1と0のバイナリービットが、CPU、GPU、メモリといったハードウェアに入力され、そのあと順番に情報処理演算が実行され、最終的にバイナリーで出力される。

画像クレジット:Walden Kirsch/Intel Corporation

一方、ニューロモーフィック・コンピューターでは、「スパイク・インプット」と呼ばれる離散的な電気信号のセットが、プロセッサによって構築される「スパイキング・ニューラルネットワーク(SNN)」に供給される。ソフトウェアベースのニューラルネットワークが、ヒトの脳を模倣した機械学習アルゴリズムの集合体であるのに対し、SNNシステムは、そのような情報伝達方式を物理的に具現化したものだ。SNNでは並列処理が可能であり、演算処理のあとには「スパイク・アウトプット」が計測される。

Hala PointとLoihi 2プロセッサは、脳におけるニューロンと同じように、多数のノードが相互接続し、情報処理が複数のレイヤーでおこなわれるSNNシステムを構築している。また、このチップでは、メモリと演算能力が一カ所に統合されている。従来のコンピューターでは、演算能力とメモリは独立しており、データが物理的にコンポーネントのあいだを移動しなくてはならないため、ボトルネックが生じていた。SNNでは前述の特徴により、並列処理が可能となるため、電力消費が削減できる。

ニューロモーフィック・コンピューティングが、AIのゲームチェンジャーになり得る理由

初期の研究によると、Hala PointはAIワークロードに関して、15兆TOPS/W(1ワットあたり1秒間の演算回数)という高いエネルギー効率を実現した。ほとんどの従来型ニューラルプロセッシングユニット(NPU)、およびその他のAIシステムの演算効率は、10TOPS/Wを大きく下回る。

ニューロモーフィック・コンピューティングは発展途上の分野であり、Hala Pointのようなマシンはまだほとんど実用化されていない。ただし例外として、オーストラリアのウエスタン・シドニー大学にある国際ニューロモーフィック・システムセンター(ICNS)の研究チームは2023年12月、類似のマシンを実用化する計画を発表している。

ICNS研究チームの発表によれば、「DeepSouth」と名付けられたこのマシンは、1秒あたり228兆回のシナプス演算でスパイキング・ニューロンの大規模ネットワークをエミュレートでき、これはヒトの脳の演算速度に匹敵する。

一方、Hala Pointは「出発点」、すなわち研究用のプロトタイプであり、将来的に実用化可能なシステムに組み込まれる見込みであると、インテルの担当者は述べている。

ニューロモーフィック・コンピューターは今後、新たなデータからの学習を継続的に行うChatGPTのような大規模言語モデル(LLM)へと発展する可能性もある。そうなれば、現在のAI運用に不可欠な「膨大なトレーニング」という負荷の軽減につながるかもしれない。